반응형

Index

딥러닝은 머신러닝에 속하는 개념으로, (Deep) Neural Network 를 기반으로 한 학습모델이다. 많은 layer를 progressive하게 학습시켜 high level feature를 뽑아내기 때문에, 일반적으로 머신러닝 대비해서 훨씬 큰 사이즈의 데이터로 학습할때 성능이 좋고, 다만 많은 layer와 node로 인해 black box와 같이 어떻게 결론에 도달했는지 해석력이 부족한 단점이 있다.

Perceptron

- 딥러닝의 기본이 되는 Neural Network는 인간의 신경망 구조모양을 본떠만든 Perceptron으로 시작

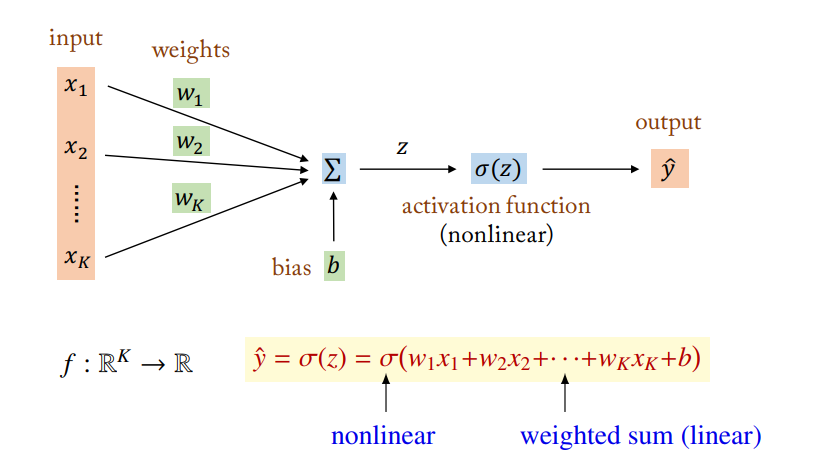

- input node(x)에 weight(w)를 곱하고 bias(b)를 더한 선형결합에 nonlinear한 activation function(활성화 함수)을 씌워 output을 만드는 구조이다. 뒤에 다루겠지만 활성화함수가 linear하면 layer를 여러개 쌓는 의미가 없게된다.

MLP (Multi-Layer-Perceptron)

- 단층 Perceptron으로는 선형적인 문제만 풀 수 있기때문에 여러개 Layer를 쌓아 MLP를 만든다.

- MLP는 크게 input - hidden - output layer 로 구성되어있으며 hidden layer 의 개수가 많을수록 deep하다고 표현한다

- Deep한 모델일 수록, 뒤의 layer로 갈수록 feature의 퀄리티가 높다.

- 'Node'는 layer에 있는 각각의 뉴런들이고, inputs을 w,b로 선형결합하고 활성화함수를 취하는 '객체'이다. 그리고 'Feature'는 node로 부터 계산된 결과값이다. (두개 용어는 혼용되기도 함)

- Activation function으로는 주로 Sigmoid가 사용되는데 nonlinear 하면서 differentiable 하여 backpropagation 하기에 용이하기 때문이다.

- hidden layer(은닉층)과는 다르게, 마지막 output layer에는 Softmax 함수가 사용되는데, 이는 실제 확률을 의미하는건 아니지만 확률과 비슷하게 ouput node들이 전부 0~1사이의 값을 가지면서 합이 1이 되게 해준다.

- Softmax 의 input으로 사용되는 Z값은 보통 logit이라고 부른다. logit은 sigmoid의 역함수 모양으로 [-∞,∞] 범위의 값이다.

반응형

'Study > DL' 카테고리의 다른 글

| CNN - 1편 (CNN의 구조) (0) | 2023.06.29 |

|---|---|

| Dropout 과 Batch Normalization (0) | 2023.06.29 |

| 활성화함수(Activation function)와 Optimizer (0) | 2023.06.29 |

| 역전파(Backpropagation)와 Vanishing gradient (0) | 2023.06.29 |

| 비용함수(Cost function)와 경사하강법(Gradient Descent) (0) | 2023.06.29 |

댓글